目录

- Spring Boot 整合 Java Deeplearning4j 实现医学影像诊断功能

- 一、引言

- 二、技术概述

- (一)Spring Boot

- (二)Deeplearning4j

- (三)神经网络选择

- 三、数据集介绍

- (一)数据集来源

- (二)数据集格式

- 四、Maven 依赖

- 五、代码实现

- (一)数据预处理

- (二)模型构建

- (三)模型训练

- (四)模型预测

- 六、单元测试

- 七、预期输出

- 八、参考资料

博主简介:历代文学网(PC端可以访问:https://literature.sinhy.com/,移动端可微信小程序搜索“历代文学”)总架构师,15年工作经验,精通Java编程,高并发设计,Springboot和微服务,熟悉linux,ESXI虚拟化以及云原生docker和K8s,热衷于探索科技的边界,并将理论知识转化为实际应用。保持对新技术的好奇心,乐于分享所学,希望通过我的实践经历和见解,启发他人的创新思维。在这里,我希望能与志同道合的朋友交流探讨,共同进步,一起在技术的世界里不断学习成长。

Springboot整合Java DL4J实现交通标志识别系统全过程

Spring Boot 整合 Java Deeplearning4j 实现医学影像诊断功能

一、引言

在医学领域,准确快速地诊断疾病对于患者的治疗至关重要。随着人工智能技术的发展,深度学习在医学影像诊断中展现出了巨大的潜力。本文将介绍如何使用 Spring Boot 整合 Java Deeplearning4j 来实现一个医学影像诊断的案例,辅助医生诊断 X 光片、CT 扫描等医学影像,检测病变区域。

二、技术概述

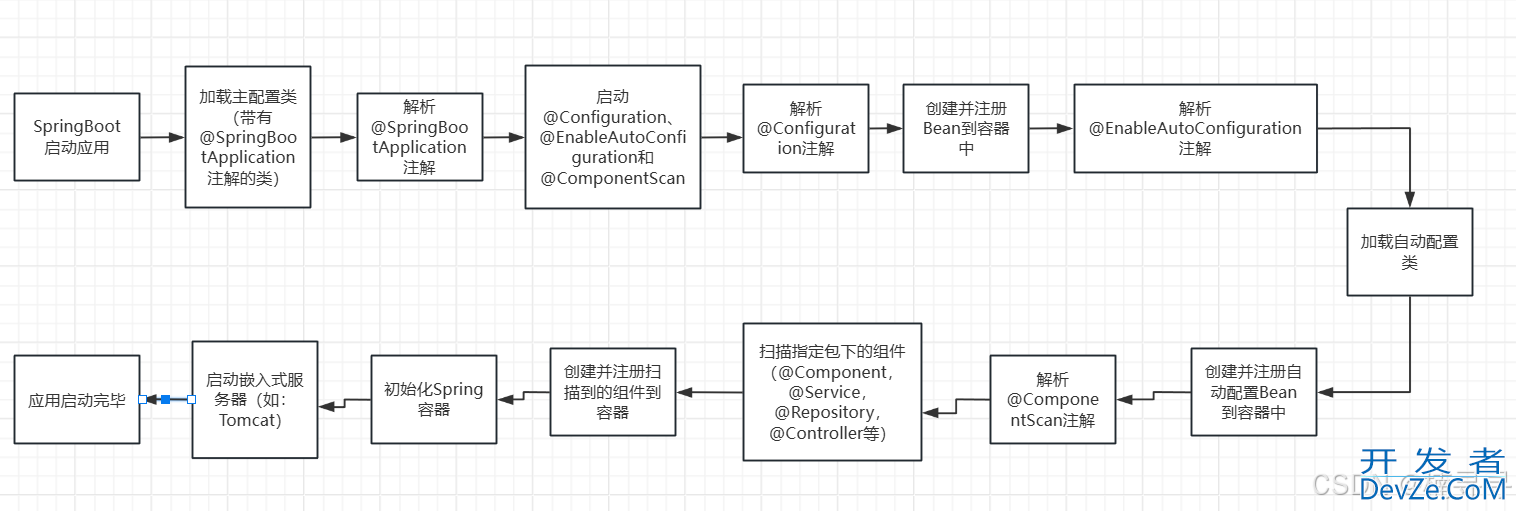

(一)Spring Boot

Spring Boot 是一个用于快速开发 Java 应用程序的框架。它简化了 Spring 应用程序的配置和部署,提供了自动配置、起步依赖等功能,使开发者能够更加专注于业务逻辑的实现。

(二)Deeplearning4j

Deeplearning4j 是一个基于 Java 和 Scala 的深度学习库,支持多种深度学习算法和神经网络架构。它提供了高效的数值计算、分布式训练等功能,适用于处理大规模数据和复杂的深度学习任务。

(三)神经网络选择

在本案例中,我们选择使用卷积神经网络(Convolutional Neural Network,CNN)来实现医学影像诊断。CNN 是一种专门用于处理图像数据的神经网络,具有以下优点:

- 局部连接:CNN 中的神经元只与输入图像的局部区域相连,减少了参数数量,提高了计算效率。

- 权值共享:CNN 中的卷积核在不同位置共享权值,进一步减少了参数数量,同时也提高了模型的泛化能力。

- 层次结构:CNN 通常由多个卷积层、池化层和全连接层组成,能够自动学习图像的层次特征,从低级特征到高级特征逐步提取。

三、数据集介绍

(一)数据集来源

我们使用公开的医学影像数据集,如 Kaggle 上的医学影像数据集。这些数据集通常包含大量的 X 光片、CT 扫描等医学影像,以及对应的病变区域标注。

(二)数据集格式

数据集通常以图像文件和标注文件的形式存储。图像文件可以是常见的图像格式,如 JPEG、PNG 等。标注文件可以是文本文件、XML 文件或其他格式,用于记录病变区域的位置和类别信息。

以下是一个简单的数据集目录结构示例:

dataset/ ├── images/ │ ├── image1.jpg │ ├── image2.jpg │ ├──... ├── labels/ │ ├── label1.txt │ ├── label2.txt │ ├──...

在标注文件中,每行表示一个病变区域的标注信息,格式可以如下:

image_filename,x1,y1,x2,y2,class

其中,image_filename 是对应的图像文件名,x1,y1,x2,y2 是病变区域的左上角和右下角坐标,class 是病变区域的类别。

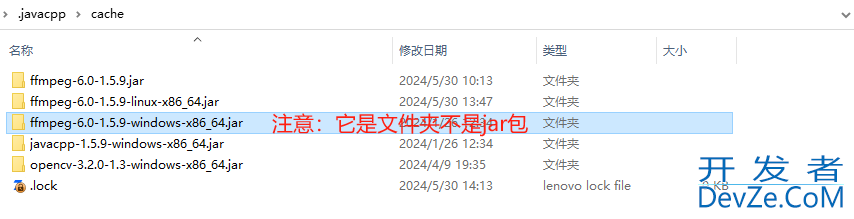

四、Maven 依赖

在项目的 pom.xml 文件中,需要添加以下 Maven 依赖:

<dependency>

<groupId>org.deeplearning4j</groupId>

<artifactId>deeplearning4j-core</artifactId>

<version>1.0.0-beta7</version>

</dependency>

<dependency>

<groupId>org.deeplearning4j</groupId>

<artifactId>deeplearning4j-nn</artifactId>

<version>1.0.0-beta7</version>

</dependency>

<dependency>

<groupId>org.deeplearning4j</groupId>

<artifactId>deeplearning4j-ui</artifactId>

<version>1.0.0-beta7</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

五、代码实现

(一)数据预处理

首先,我们需要对数据集进行预处理,将图像数据转换为适合神经网络输入的格式。以下是一个数据预处理的示例代码:

import org.datavec.image.loader.NativeImageLoader;

import org.deeplearning4j.nn.graph.ComputationGraph;

import org.deeplearning4j.util.ModelSerializer;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.dataset.api.preprocessor.DataNormalization;

import org.nd4j.linalg.dataset.api.preprocessor.ImagePreProcessingScaler;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import java.io.File;

import java.io.IOException;

import java.util.ArrayList;

import java.util.List;

public class DataPreprocessor {

private static final Logger logger = LoggerFactory.getLogger(DataPreprocessor.class);

public static List<INDArray> preprocessImages(String datasetPath) throws IOException {

List<INDArray> images = new ArrayList<>();

File imagesDir = new File(datasetPath + "/images");

for (File imageFile : imagesDir.listFiles()) {

NativeImageLoader loader = new NativeImageLoader(224, 224, 3);

INDArray image = loader.asMatrix(imageFile);

DataNormalization scaler = new ImagePreProcessingScaler(0, 1);

scaler.transform(image);

images.add(image);

}

return images;

}

}

在上述代码中,我们使用 NativeImageLoader 类加载图像数据,并将其转换为 INDArray 格式。然后,我们使用 ImagePrePjsrocessingScaler 类对图像数据进行归一化处理,将像素值范围缩放到 0-1 之间。

(二)模型构建

接下来,我们构建一个卷积神经网络模型。以下是一个模型构建的示例代码:

import org.deeplearning4j.nn.conf.ComputationGraphConfiguration;

import org.deeplearning4j.nn.conf.NeuralNetConfiguration;

import org.deeplearning4j.nn.conf.inputs.InputType;

import org.deeplearning4j.nn.conf.layers.ConvolutionLayer;

import org.deeplearning4j.nn.conf.layers.DenseLayer;

import org.deeplearning4j.nn.conf.layers.OutputLayer;

import org.deeplearning4j.nn.graph.ComputationGraph;

import org.nd4j.linalg.activations.Activation;

import org.nd4j.linalg.lossfunctions.LossFunctions;

public class ModelBuilder {

public static ComputationGraph buildModel() {

ComputationGraphConfiguration.GraphBuilder graphBuilder = new NeuralNetConfiguration.Builder()

.seed(12345)

.updater(org.deeplearning4j.nn.weights.WeightInit.XAVIER)

.l2(0.0001)

.graphBuilder()

.addInputs("input")

.setInputTypes(InputType.convolutional(224, 224, 3))

.addLayer("conv1", new ConvolutionLayer.Builder(3, 3)

.nIn(3)

.nOut(32)

.activation(Activation.RELU)

.build(), "input")

.addLayer("conv2", new ConvolutionLayer.Builder(3, 3)

.nIn(32)

.nOut(64)

.activation(Activajavascripttion.RELU)

.build(), "conv1")

.addLayer("pool1", new org.deeplearning4j.nn.conf.layers.Pooling2D.Builder(org.deeplearning4j.nn.conf.layers.Pooling2D.PoolingType.MAX)

.kernelSize(2, 2)

.stride(2, 2)

.build(), "conv2")

.addLayer("conv3", new ConvolutionLayer.Builder(3, 3)

.nIn(64)

.nOut(128)

.activation(Activation.RELU)

.build(), "pool1")

.addLayer("conv4", new ConvolutionLayer.Builder(3, 3)

.nIn(128)

.nOut(256)

.activation(Activation.RELU)

.build(), "conv3")

.addLayer("pool2", new org.deeplearning4j.nn.conf.layers.Pooling2D.Builder(org.deeplearning4jphp.nn.conf.layers.Pooling2D.PoolingType.MAX)

.kernelSize(2, 2)

.stride(2, 2)

.build(), "conv4")

.addLayer("flatten", new org.deeplearning4j.nn.conf.layers.FlattenLayer.Builder().build(), "pool2")

.addLayer("fc1", new DenseLayer.Builder()

.nIn(256 * 28 * 28)

.nOut(1024)

.activation(Activation.RELU)

.build(), "flatten")

.addLayer("dropout", new org.deeplearning4j.nn.conf.layers.DropoutLayer.Builder()

.dropOut(0.5)

.build(), "fc1")

.addLayer("fc2", new DenseLayer.Builder()

.nIn(1024)

.nOut(512)

.activation(Activation.RELU)

.build(), "dropout")

.addLayer("output", new OutputLayer.Builder(LossFunctions.LossFunction.NEGATIVELOGLIKELIHOOD)

.nIn(512)

.nOut(2) // Assuming two classes: normal and abnormal

.activation(Activation.SOFTMAX)

.build(), "fc2")

.setOutputs("output");

return new ComputationGraph(graphBuilder.build());

}

}

在上述代码中,我们使用 ComputationGraphConfiguration 类构建一个卷积神经网络模型。模型包含多个卷积层、池化层、全连接层和输出层。我们使用 NeuralNetConfiguration.Builder 类设置模型的参数,如随机种子、权重初始化方法、正则化系数等。

(三)模型训练

然后,我们使用预处理后的数据集对模型进行训练。以下是一个模型训练的示例代码:

import org.deeplearniwww.devze.comng4j.nn.graph.ComputationGraph;

import org.deeplearning4j.optimize.listeners.ScoreIterationListener;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

import org.nd4j.linalg.lossfunctions.LossFunctions;

import java.io.File;

import java.io.IOException;

public class ModelTrainer {

public static void trainModel(ComputationGraph model, DataSetIterator trainIterator, int numEpochs) throws IOException {

model.init();

model.setListeners(new ScoreIterationListener(10));

for (int epoch = 0; epoch < numEpochs; epoch++) {

model.fit(trainIterator);

System.out.println("Epoch " + epoch + " completed.");

}

File modelSavePath = new File("trained_model.zip");

org.deeplearning4j.nn.modelio.ModelSerializer.writeModel(model, modelSavePath, true);

}

}

在上述代码中,我们使用 ComputationGraph 类的 fit 方法对模型进行训练。我们可以设置训练的轮数 numEpochs,并在每一轮训练结束后打印训练进度信息。训练完成后,我们使用 ModelSerializer 类将模型保存到文件中。

(四)模型预测

最后,我们使用训练好的模型对新的医学影像进行预测。以下是一个模型预测的示例代码:

import org.deeplearning4j.nn.graph.ComputationGraph;

import org.nd4j.linalg.api.ndarray.INDArray;

import org.nd4j.linalg.dataset.api.preprocessor.DataNormalization;

import org.nd4j.linalg.dataset.api.preprocessor.ImagePreProcessingScaler;

import org.nd4j.linalg.factory.Nd4j;

import java.io.File;

import java.io.IOException;

public class ModelPredictor {

public static int predictImage(ComputationGraph model, File imageFile) throws IOException {

// Load and preprocess the image

org.datavec.image.loader.NativeImageLoader loader = new NativeImageLoader(224, 224, 3);

INDArray image = loader.asMatrix(imageFile);

DataNormalization scaler = new ImagePreProcessingScaler(0, 1);

scaler.transform(image);

// Make prediction

INDArray output = model.outputSingle(image);

int predictedClass = Nd4j.argMax(output, 1).getInt(0);

return predictedClass;

}

}

在上述代码中,我们使用 NativeImageLoader 类加载图像数据,并使用与训练时相同的预处理方法对图像进行归一化处理。然后,我们使用 ComputationGraph 类的 outputSingle 方法对图像进行预测,得到预测结果的概率分布。最后,我们使用 Nd4j.argMax 方法获取预测结果的类别索引。

六、单元测试

为了确保代码的正确性,我们可以编写单元测试来测试各个模块的功能。以下是一个单元测试的示例代码:

import org.deeplearning4j.nn.graph.ComputationGraph;

import org.junit.jupiter.api.BeforeEach;

import org.junit.jupiter.api.Test;

import org.nd4j.linalg.dataset.api.iterator.DataSetIterator;

import java.io.File;

import java.io.IOException;

import static org.junit.jupiter.api.Assertions.assertEquals;

class ModelPredictorTest {

private ComputationGraph model;

private DataSetIterator trainIterator;

@BeforeEach

void setUp() throws IOException {

// Load the trained model

File modelFile = new File("trained_model.zip");

model = ComputationGraph.load(modelFile, true);

// Create a dummy data iterator for testing

trainIterator = null; // Replace with actual data iterator for more comprehensive testing

}

@Test

void testPredictImage() throws IOException {

// Load a test image

File testImage = new File("test_image.jpg");

// Make prediction

int predictedClass = ModelPredictor.predictImage(model, testImage);

// Assert the predicted class

assertEquals(0, predictedClass); // Replace with expected predicted class

}

}

在上述代码中,我们首先加载训练好的模型,并创建一个测试数据迭代器(这里使用了一个空的迭代器,实际应用中可以使用真实的测试数据集)。然后,我们加载一个测试图像,并使用 ModelPredictor.predictImage 方法对图像进行预测。最后,我们使用 assertEquals 方法断言预测结果是否符合预期。

七、预期输出

在训练过程中,我们可以预期看到模型的损失值逐渐下降,准确率逐渐提高。在预测过程中,我们可以预期得到一个整数,表示预测的类别索引。例如,如果我们有两个类别:正常和异常,那么预测结果可能是 0 表示正常,1 表示异常。

八、参考资料

Deeplearning4j 官方文档

Spring Boot 官方文档

Kaggle 医学影像数据集

到此这篇关于Springboot 整合 Java DL4J 实现医学影像诊断功能的文章就介绍到这了,更多相关Springboot Java DL4J医android学影像诊断内容请搜索编程客栈(www.devze.com)以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程客栈(www.devze.com)!

加载中,请稍侯......

加载中,请稍侯......

精彩评论