目录

- python库XGBoost

- 为什么选择 XGBoost?

- XGBoost 的工作原理

- 何时使用 XGBoost

- 代码示例

python库XGBoost

今天给大家分享一个神奇的 python 库,XGBoost

https://github.com/dmlc/xgboost

XGBoost 是 eXtreme Gradient Boosting 的缩写,是一个开源的 python 库,它提供了梯度提升决策树的高效且可扩展的实现。XGBoost 专为速度和性能而设计,广泛应用于机器学习竞赛和实际应用中。它支持各种目标函数,包括回归、分类和排名任务。

为什么选择 XGBoost?

效率,XGBoost 以其计算速度而闻名,这使得它比梯度提升的其他实现更快。

可扩展性,它可以跨多个 CPU 甚至 GPandroidU 无缝扩展,使其适合大型数据集。

性能,XGBoost 的性能往往优于其他算法,尤其是在涉及结构化数据的场景中。

灵活性,它支持各种损失函数和定制,使其适用于广泛的应用。

正则化,XGBoost 包括 L1 和 L2 正则化,有助于防止过度拟合并提高模型泛化能力。

XGBoost 的工作原理

XGBoost 是梯度提升的一种形式,是一种强大的机器学习技术,用于回归和分类任务。梯度提升涉及通过添加弱学习器(通常是决策树)来增量构建模型,以纠正现有模型的错误。该过程通过将新模型拟合先前模型的残差来迭代地改进预测。

XGBoost 涉及三个主要组件:要最小化的损失函数、进行预测的弱学习器以及添加弱学习器以最小化损失函数的加性模型。

损失函数:XGBoost 需要一个可微的损失函数,它衡量预测结果和实际结果之间的差异。

弱学习器:XGBoost 使用决策树作为弱学习器。

加法模型:添加新树来纠正现有树产生的残差。随着更多树木的添加,模型变得更加强大。

XGBoost 还实现了树的修剪、正则化和处理缺失值等各种技术,使其成为一种强大的算法。

何时使用 XGBoost

以下是一些需要考虑的准则。

结构化或表格数据:XGBoost 在结构化或表格数据上表现异常出色,例如 CSV 文件。

大型数据集:XGBoost 凭借其可扩展性和并行处理能力,可以有效地处理大量数据。

高维空间:XGBjavascriptoost 可以处理大量特征,无需进行特征约简,非常适合所有特征都携带重要信息的场景。

分类和回归任务:XGBoost 非常适合分类(二元和多类)和回归任务,使其适用于各种类型的预测www.devze.com建模。

代码示例

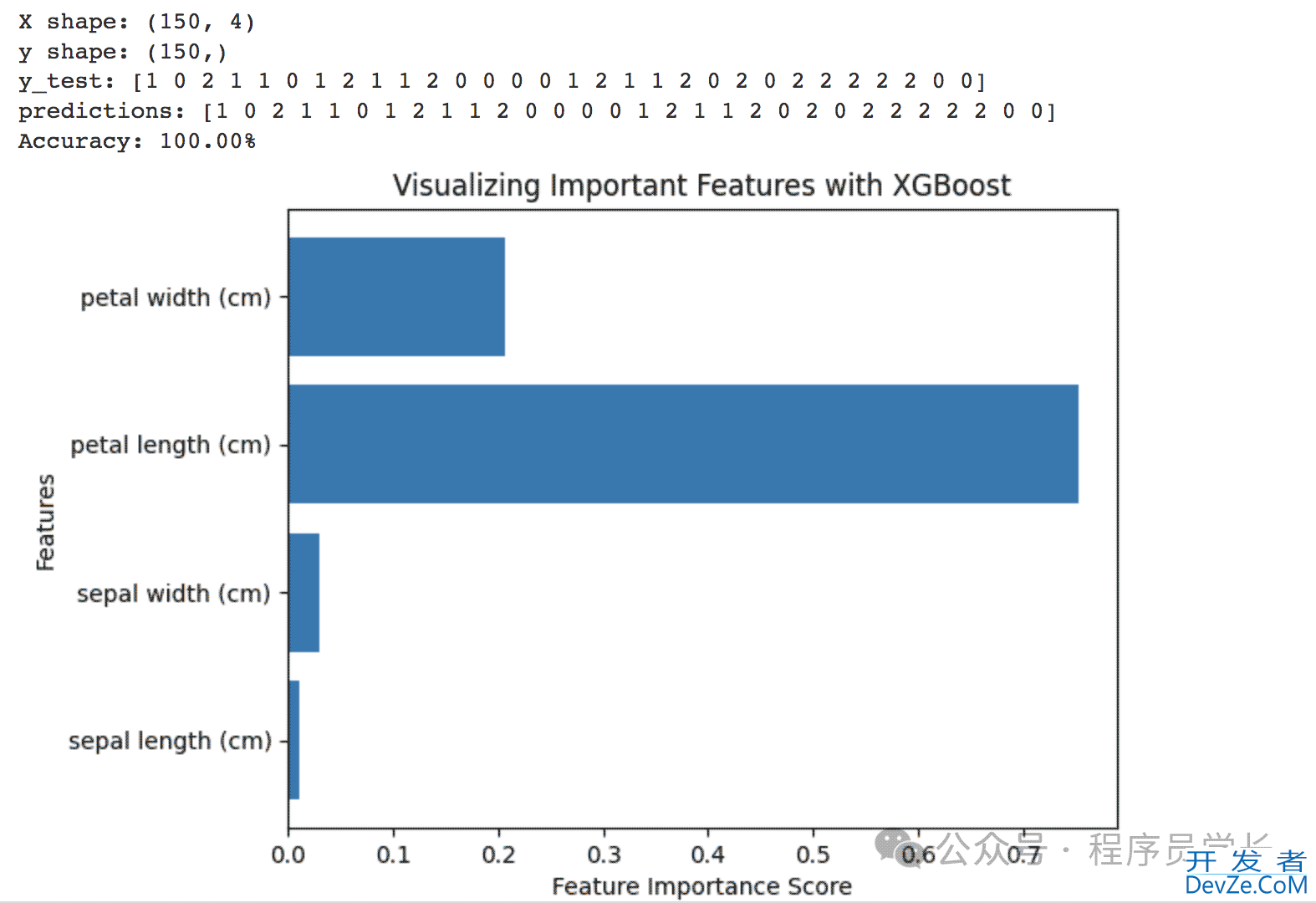

以下是在 Python 中使用 XGBoost 进行分类的基本示例。

在此示例中,我们使用 Iris 数据集,这是机器学习中流行的数据集。我们将数据分为训练集和测试集,创建 XGBoost 分类器,在训练数据上对其进行训练,然后在测试数据上评估其性能。

import xgboost as xgb

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_iris

from sklearn.metrics import accuracy_score

import matplotlib.pyplot as plt

# Load dataset

iris = load_iris()

X, y = iris.data, iris.target

print('X shape:', X.shape)

print('y shape:', y.shape)

# Split dataset into train and test sets

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.2, random_state=42)

# Instantiate an XGBoost classifier

model = xgb.XGBClassifier()

# Train the model

model.fit(X_train, y_train)

# Make predictions

predictions = model.predandroidict(X_test)

# EvaLuate the model

accuracy = accuracy_score(y_test, predictions)

print('y_test:', y_test)

print('predictions:', predictions)

print(f"Accuracy: {accuracy * 100:.2f}%")

# Feature importance

feature_importance = model.feature_importances_

# Plotting feature importance

plt.barh(iris.编程feature_names, feature_importance)

plt.xlabel('Feature Importance Score')

plt.ylabel('Features')

plt.title('Visualizing Important Features with XGBoost')

plt.show()

以上就是python机器学习XGBoost梯度提升决策树的高效且可扩展实现的详细内容,更多关于python XGBoost机器学习的资料请关注编程客栈(www.devze.com)其它相关文章!

加载中,请稍侯......

加载中,请稍侯......

精彩评论