目录

- 反向传播求导

- 代码

反向传播求导

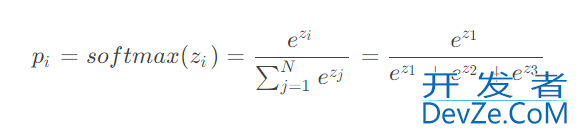

可以看到,so开发者_JAVA开发ftmax 计算了多个神经元的输入,在反javascript向传播求导时,需要考虑对不同神经元的参数求导。

分两种情况考虑:

- 当求导的参数位于分子时

- 当求导的参数位编程于分母时

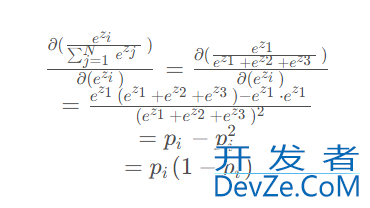

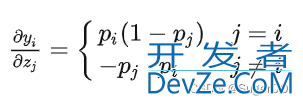

当求导的参数位于分子时:

当求导的参数位于分母时(ez2 or ez3这两个是对称的,求导结果是一样的):

代码

import torch

import math

def my_softmax(features):

_sum = 0

for i in features:

www.devze.com python _sum += math.e ** i

return torch.Tensor([ math.e ** i / _sum for i in features ])

def my_softmax_grad(outputs):

n = len(outputs)

grad = []

for i in range(n):

temp = []

for j in range(n):

javascript if i == j:

temp.append(outputs[i] * (1- outputs[i]))

else:

temp.append(-outputs[j] * outputs[i])

grad.append(torch.Tensor(temp))

return grad

if __name__ == '__main__':

features = torch.randn(10)

features.requires_grad_()

torch_softmax = torch.nn.functional.softmax

p1 = torch_softmax(features,dim=0)

p2 = my_softmax(features)

print(torch.allclose(p1,p2))

n = len(p1)

p2_grad = my_softmax_grad(p2)

for i in range(n):

p1_grad = torch.autograd.grad(p1[i],features, retain_graph=True)

print(torch.allclose(p1_grad[0], p2_grad[i]))

到此这篇关于python实现softmax反向传播的示例代码的文章就介绍到这了,更多相关Python softmax 反向传播内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

加载中,请稍侯......

加载中,请稍侯......

精彩评论