目录

- 引言

- Redis 的基础特性

- 亿级数据读取策略

- 1. 分片与集群

- 2. 使用管道(Pipeline)

- 3. 批量读取(MGET、HGETALL)

- 4. 数据分页

- 5. 读写分离

- 实战案例分析

- 场景描述

- 解决方案

- 结论

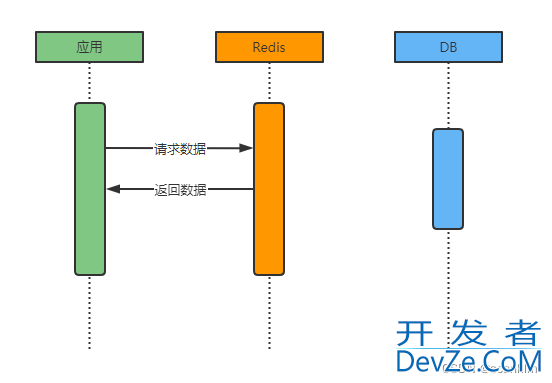

引言

随着数据量的爆炸式增长,如何在亿级数据规模下实现高效的数据读取成为了许多企业和开发者面临的重大挑战。Redis 作为一款高性能的键值数据库,以其卓越的性能和丰富的数据结构支持,成为了处理大规模数据读取的理想选择。本文将深入探讨 Redis 在亿级数据读取中的应用,通过理论分析和实战代码样例,帮助读者更好地理解和应用 Redis。

Redis 的基础特性

http://www.devze.com高性能

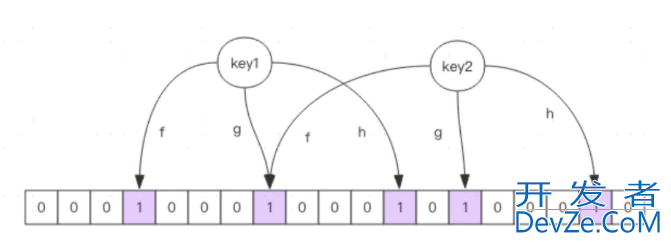

Redis 采用内存存储,支持多种数据结构(如字符串、列表、集合、哈希表、有序集合等),同时提供了丰富的原子操作和批量操作命令,这些特性使得 Redis 在处理高速读写操作时表现出色。丰富的数据结构

Redis 支持多种数据结构,这些数据结构各有特点,能够满足不同的业务需求。例如,列表(List)适用于需要按顺序存取的场景;集合(Set)适用于需要快速去重的场景;哈希表(Hash)适用于存储对象类型的数据;有序集合(ZSet)则适用于需要排序的场景。亿级数据读取策略

1. 分片与集群

当数据量达到亿级时,单个 Redis 实例可能无法承载全部数据。此时,可以采用分片(Sharding)或集群(Cluster)技术将数据分散存储在多个节点上。

分片示例代码

// 创建多个 Redis 实例

JediphpsShardInfo shardInfo1 = new JedisShardInfo("localhost", 6379);

JedisShardInfo shardInfo2 = new JedisShardInfo("localhost", 6380);

// 创建 ShardedJedisPool

List<JedisShardInfo> shardInfos = Arrays.asList(shardInfo1, shardInfo2);

ShardedJedisPool pool = new ShardedJedisPool(new JedisPoolConfig(), shardInfos);

// 从 pool 中获取 ShardedJedis 实例

try (ShardedJedis jedis = pool.getResource()) {

jedis.set("key", "value");

String value = jedis.get("key");

}

集群示例代码

// 创建 Redis 集群节点

Set<HostAndPort> clusterNodes = new HashSet<>();

clusterNodes.add(new HostAndPort("localhost", 7000));

clusterNodes.add(new HostAndPort("localhost", 7001));

// 创建 JedisCluster

JedisCluster cluster = new JedisCluster(clusterNodes);

// 使用 JedisCluster 读取数据

String value = cluster.get("key");

2. 使用管道(Pipeline)

Redis 的管道技术可以将多个命令打包成一个包发送给服务器,然后一次性返回结果,这样可以显著减少网络传输的次数和延迟。

try (Jedis jedis = new Jedis("localhost")) {

Pipeline pipeline = jedis.pipelined();

Response<String> response1 = pipeline.get("key1");

Response<String> response2 = pipeline.get("key2");

pipeline.sync();

String value1 = response1.get();

String value2 = response2.get();

}

3. 批量读取(MGET、HGETALL)

对于需要批量读取的场景,Redis 提供了 MGET 和 HGETALL 命令。MGET 可以一次性获取多个键的值,而 HGETALL 则可以获取哈希表中所有的键值对。

# MGET 示例 MGET key1 key2 key3 # HGETALL 示例 HGETALL hashKey

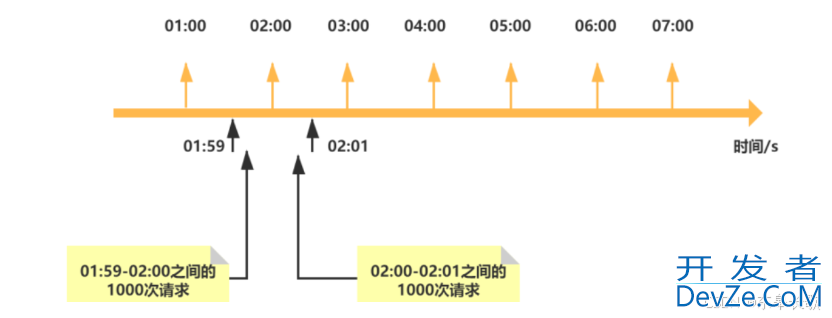

4. 数据分页

对于数据量极大的场景,可以采用分页查询的方式,每次只查询一部分数据,避免一次性加载大量数据导致的性能问题。

5. 读写分离

如果读操作远多于写操作,可以考虑将读操作和写操作分别分配到不同的 Redis 节点上,实现读写分离,从而提高读取效率。

实战案例分析

场景描述

假设有一个电商平台,每天需要处理数亿条订单数据。我们需要使用 Redis 来存储和读取这些订单数据,以支持快速的数据查询和分析。

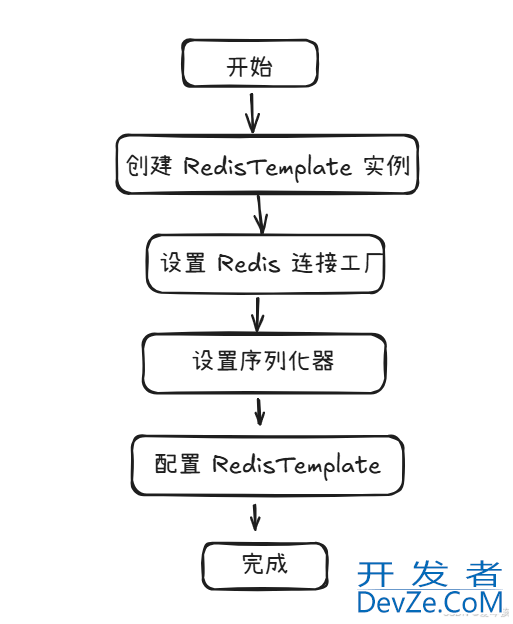

解决方案

1.数据分片:根据订单ID的哈希值将订单数据分布到多个 Redis 实例上,每个实例负责一部分数据的存储和读取。

2.使用 Pipeline:在批量查询订单数据时,使用 Pipeline 批量发送请求,减少网络延迟。

3.MGET 批量读取:对于需要同时查询多个订单的场景,使用 MGET 命令批量获取订单数据。

4.持久化机制:为了数据安全,采用 AOF 持久

5.集群部署与扩展

- Redis Cluster:采用 Redis 自带的集群功能,通过多个节点组成集群,实现数据的自动分片、负载均衡和故障转移。Redis Cluster 支持水平扩展,可以随着业务量的增长增加节点,提高系统的处理能力和容错性。

- 集群监控:部署 R编程客栈edis 集群监控工具(如 RedisInsight、RedisLive 等),实时监控集群的状态、性能指标和节点健康情况,及时发现并解决问题。

6. 数据压缩与淘汰策略

- 数据压缩:对于存储的字符串类型数据,如果数据本身具有可压缩性(如 jsON 字符串、文本数据等),可以考虑在客户端或 Redis 服务器端进行压缩后再存储,以减少内存占用。Redis 4.0 以上版本支持 LZF 压缩算法。

- 淘汰策略:根据业务需求和数据访问模式,设置合理的内存淘汰策略(如 LRU、LFU、TTL 等),以控制 Redis 的内存使用量,避免内存溢出。

7. 索引与查询优化

- 有序集合(ZSet):对于需要频繁进行排序和范围查询的数据,可以使用 Redis 的有序集合(ZSet)来存储。通过为数据设置合适的分数(score),可以实现快速的android排序和范围查询。

- 二级索引:如果 Redis 本身的数据结构无法满足复杂的查询需求,可以考虑在 Redis 外部建立二级索引(如使用 Redis Hash 或其他数据库系统),并在查询时结合使用 Redis 和二级索引来提高查询效率。

8. 安全性与权限控制

- 密码保护:为 Redis 设置访问密码,防止未授权访问。

- 网络隔离:将 Redis 部署在安全的网络环境中,通过防火墙、VPN 等手段进行网络隔离,确保数据的安全性。

- 权限控制:在 Rephpdis 集群中实施细粒度的权限控制,限制不同用户或应用程序对数据的访问权限。

9. 备份与恢复

- 定期备份:定期备份 Redis 数据,以防数据丢失或损坏。可以使用 Redis 的 RDB 快照或 AOF 日志进行备份。

- 数据恢复:在数据丢失或系统故障时,能够快速恢复 Redis 数据,确保业务的连续性。

10. 性能调优

- 硬件优化:升级服务器硬件(如 CPU、内存、网络带宽等),提高 Redis 的处理能力。

- 配置优化:根据业务需求和 Redis 的性能表现,调整 Redis 的配置参数(如内存限制、持久化策略、网络设置等),以达到最佳的性能表现。

- 代码优化:优化客户端代码,减少不必要的网络请求和数据传输,提高数据读取的效率。

结论

Redis 在处理亿级数据读取时展现出了卓越的性能和灵活性。通过合理的数据分片、集群部署、查询优化、数据压缩与淘汰策略以及安全性与权限控制等措施,我们可以进一步提高 Redis 的处理能力和稳定性,满足大规模数据读取的需求。同时,我们也需要不断关注 Redis 的新技术和最佳实践,以便在实际应用中更好地发挥 Redis 的优势。

到此这篇关于redis 亿级数据读取的实现的文章就介绍到这了,更多相关redis 亿级数据读取内容请搜索编程客栈(www.devze.com)以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程客栈(www.devze.com)!

加载中,请稍侯......

加载中,请稍侯......

精彩评论