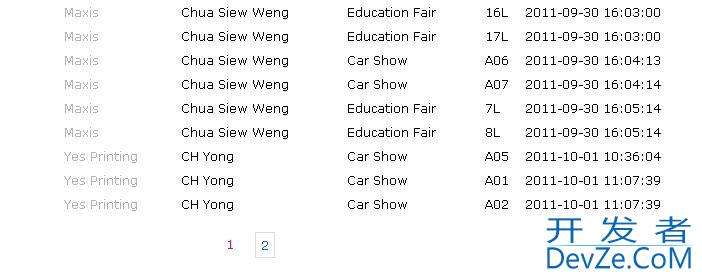

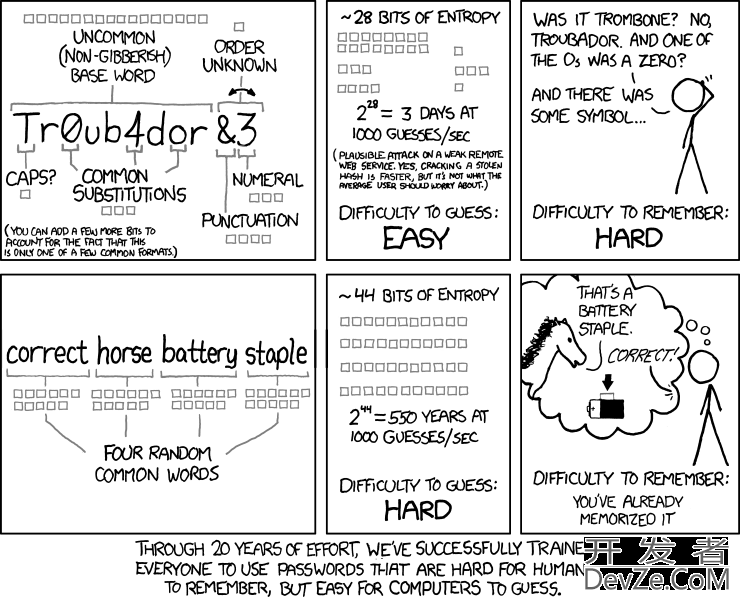

注:随着越来越多的事物依赖于越来越难以捉摸的人工智能(AI),发现后者的缺陷变得越来越重要,本文的黑盒研究也变得越来越必不可少。上面的图案是什么?是简单的黄黑条纹。但是,如果问最先进的人工智能,它给出的答案会是校车,而且有99%的把握。但是AI错了。

诚然,现在的计算机图像识别技术非常先进。比如下面的图片AI无法识别戴墨西哥帽的吉娃娃狗(说实话,有些人可能无法识别),但至少可以识别戴宽边帽的狗。然而,怀俄明大学进化人工智能实验室最近的一项研究表明,这些人工智能可能并不总是那么聪明。如开头的例子,最先进的人工智能将这些随机生成的简单图像视为鹦鹉、乒乓球拍、百吉饼或蝴蝶。

这一发现迫使我们承认一个明显但重要的事实:计算机视觉与人类视觉不同。由于我们越来越依赖神经网络来训练计算机识别图像,我们人类甚至不知道计算机在想什么。

用进化算法欺骗AI

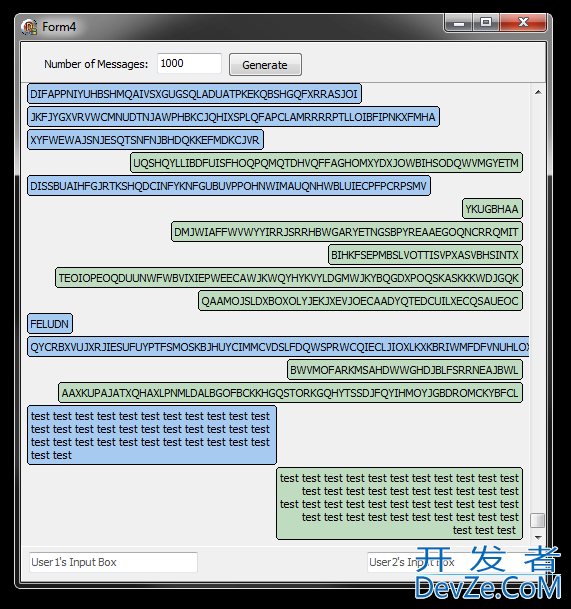

进化算法生成的随机图像,图像下面的文字就是AI识别的对象。

找出这些自我训练算法的智能的一个方法是看看它们的愚蠢。研究人员决定看看最先进的图像识别神经网络是否容易受到主动错误信息的影响。比如,如果这些神经网络可以识别猫,那么它们还会把其他东西识别为猫吗?

因此,研究人员使用进化算法生成随机图像作为视觉诱饵。他们首先使用程序生成一个图像,然后对图像进行细微的修改。然后,将原始图像和稍加修改的图像提交给基于ImageNet训练的神经网络。如果人工智能认为修改后的图比原始图更接近物体,研究人员会保留修改后的图并重复该过程。否则,回去再试一次。结果,最好的观众幸存了下来——或者说,计算机最容易识别的图像幸存了下来(不是最合适的图像——原始图像)。

最后,该技术生成了数十幅图像,神经网络的置信度超过99%。有的是蓝色和橙色的波浪线,有的是黄色和黑色的条纹等等,但是在AI的眼里,它们就是星鱼和校车。

黑箱配对

AI为什么会上当?有些情况是可以理解的。例如,如果你眯眼看,校车看起来确实像黄黑条纹。同样,随机生成的“蝴蝶王”看起来确实像蝴蝶翅膀,被识别为“滑雪面具”的图像看起来确实像一张夸张的脸。

然而,研究人员也发现,AI经常被纯粹的静态图像所迷惑。使用稍微不同的进化技术,研究人员生成了另一组图像(如下图)。这些图像对人类的眼睛来说几乎是一样的,就像破碎的电视上的图像一样。但是在最先进的神经网络眼里,这些就是蜈蚣、猎豹、孔雀等等。

在研究人员看来,神经网络似乎形成了各种有助于识别物体的视觉线索。这些线索有些是人类熟悉的(比如校车的例子),有些则不是。上图中的例子表明,至少在某些情况下,这些线索非常细化。也许经过训练,神经网络把一系列“绿-绿、紫-绿”的像素看成孔雀看到的图案。所以当随机生成的图像恰好产生相同的像素序列时,AI就把它当成孔雀。这说明AI可能会为每个对象推断出多个线索,并认为这些线索足以识别一个对象。

当然,这也表明神经网络的规模和复杂性超出了人类的理解范围。即使我们知道人工智能可以识别图像,但我们不知道如何识别它们。

类似研究的目的是通过逆向工程推导AI模型,找出人工智能的学习思路。虽然目前还不清楚,但最近两年的黑盒研究已经能够一窥豹的真面目。

AI的眼光有问题有问题吗?

当研究人员将研究结果提交给神经信息处理系统会议讨论时,专家们形成了两种截然不同的观点。有一个群体年龄更大,在这个领域更有经验,他们认为这个结果完全可以理解。另一组比较年轻,对研究成果的态度比较迷茫。至少一开始,我很惊讶强大的算法得到的结果是完全错误的。请记住,虽然这些人有点年轻,但他们都是在顶级AI大会上发表过文章的人。

开发者_开发百科据研究团队负责人克鲁恩说,这反映了这一领域的代际转移。几年前,做AI的人还在开发AI。现在,神经网络已经足够先进,研究人员可以使用它们。

用起来不一定是坏事。但是随着越来越多的东西建立在AI的基础上,发现AI的缺陷就显得越来越重要。把一些随机像素误认为某些动物当然没有坏处,但是如果AI在安全搜索过滤中让一些色情图片漏网,那就非常严重了。Clune希望这项研究能够启发其他研究者在算法中跟进和考虑图像的整体结构。换句话说,让计算机视觉更像人类视觉。

同时,这项研究也促使我们考虑AI中其他形式的漏洞。比如人脸识别也依赖于类似的技术,所以会有类似的缺陷。

如果计算机视觉只关注局部特征,也许安装一个3D打印鼻子可以让计算机认为你是别人。戴口罩会让你从监控系统中消失。计算机视觉的应用越广泛,这样的隐患就会越大。

但从更广泛的意义上说,这项研究给我的警告是。

们正进入自我学习系统的时代。现在,我们仍然控制着自己开发出来的东西。但随着 AI 不断自我开发自己,有一天我们发现自己搞不懂 AI 也不奇怪。“计算机做什么不再是人写代码写出来的了,”Clune 说:“这几乎是相互作用的组件间的规模效益导致的智能出现。”在这一智能的利用上我们无疑没有浪费时间。但是在我们这么做的时候是否完全理解了它就不太清楚了。

![Interactive visualization of a graph in python [closed]](https://www.devze.com/res/2023/04-10/09/92d32fe8c0d22fb96bd6f6e8b7d1f457.gif)

加载中,请稍侯......

加载中,请稍侯......

精彩评论